세계 최대 동영상 공유 서비스인 유튜브가 최근 자체 관리 규정(YouTube Community Guidelines enforcement)에 따른 동영상 관리 투명성 보고서를 공개했다.

보고서에 따르면, 유튜브는 지난해 4분기 동안 총 828만건의 동영상을 삭제하거나 비공개 처리한 걸로 나타났다. 하루 9만건이 넘는 막대한 양이다.

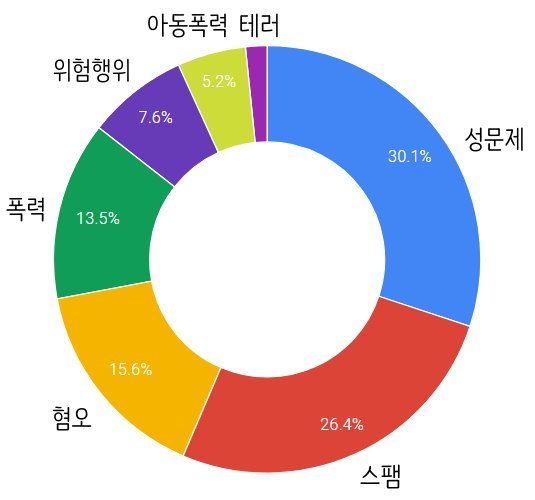

문제가 된 동영상은 성문제(30.1%)와 스팸(26.4%)이 가장 많은 비중을 차지했으며 혐오(15.6%)와 폭력(13.5%), 위험행위(7.6%), 아동폭력(5.2%), 테러조장(1.6%) 등의 순을 이뤘다.

문제 동영상을 검색하고 삭제하는 데는 주로 머신러닝에 의한 자동화 프로그램이 주를 이룬다.

때문에 삭제된 영상은 한 번도 재생되지 않고 공개되자마자 자동화 프로그램에 의해 삭제되는 경우가 76%에 달했다. 나머지 24%는 공개 후 사용자의 신고에 의해 비공개로 분류된 후 삭제됐다.

가장 많은 동영상 삭제가 이뤄진 국가는 인도, 미국, 브라질, 러시아, 독일, 영국, 멕시코, 터키, 인도네시아, 사우디아라비아 순이었다.

유튜브가 문제 된 동영상을 삭제한 현황을 공개한 것은 이번이 처음이다. 유튜브는 폭력, 성 등 부적절한 동영상 노출로 인해 각계의 비난이 고조되면서 이를 막기 위한 대책 마련에 몰두하고 있다. 이번 투명성 보고서도 이런 대책 중 하나로 공개된 것.

특히 유럽연합(EU)은 유튜브를 비롯해 페이스북, 트위터 등 서비스가 개인정보 유출과 불법 콘텐츠에 대한 대책이 미진하다며 강력한 단속을 요구하고 있다.

유튜브는 올 연말까지 관련 인력을 1만명 규모로 확대하는 것과 함께 보다 강화된 인공기능 기반의 자동화 시스템을 구축할 계획이다.

chu@fnnews.com 추현우 기자

※ 저작권자 ⓒ 파이낸셜뉴스, 무단전재-재배포 금지