[파이낸셜뉴스] 경희대학교는 경희대 컴퓨터공학부 차오닝 장(Chaoning Zhang), 홍충선, 이승규, 배성호, 김정욱 교수 연구팀이 모바일 응용 프로그램용 초경량화된 비전 기반 딥러닝 모델인 ‘MobileSAM’을 개발했다고 10일 밝혔다.

'Segment Anything Model(SAM)'은 클릭 한 번으로 이미지 속 모든 객체를 분리할 수 있어 최근 컴퓨터 비전 분야에서 혁신적인 기술로 주목받고 있다. 하지만 이미지 인코더 모델의 용량이 크고, 이미지 처리 속도가 느리다는 문제가 있다.

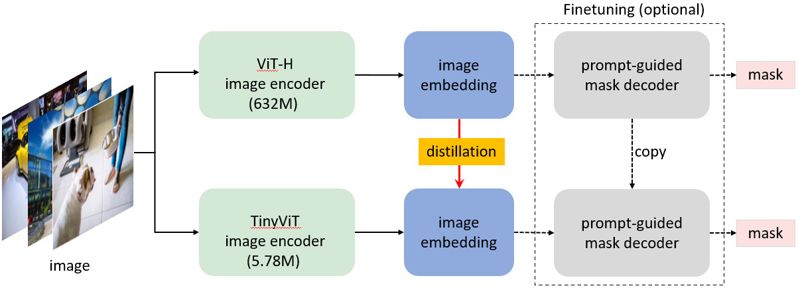

경희대 연구팀이 SAM의 기존 단점을 해결하고, 모바일 환경에서도 실시간 처리가 가능한 비전 모델을 개발했다. 연구팀이 개발한 MobileSAM은 상용 SAM 인코더 모델의 파라미터 수를 100분의 1로 줄이고 실행 속도도 60배 높였다. 이와 동시에 영상 품질은 기존 수준을 유지하는 경량화된 딥러닝 기술이다.

MobileSAM은 이미지 처리 및 컴퓨터 비전 분야에서 우수성을 인정받고 있다. 온라인 AI 전문가 커뮤니티에 빠르게 확산하며 연구자들 사이에서 주목받고 있다. 이번 연구 결과는 모바일 환경 속 딥러닝 연구에 새로운 표준을 제시했다. 이를 통해 향후 모바일, IoT 등 다양한 분야에서 딥러닝 응용개발에 활용될 전망이다.

일례로 MobileSAM은 자율주행 및 감시 분야에서도 높은 잠재력을 가지고 있다. 특히 긴급한 상황에서 적용 가능성이 크다. MobileSAM은 경량화된 딥러닝 기술을 활용해 자율주행 시스템에서 실시간 객체를 검출하고 위험 상황을 감지한다. 또한 사람의 전체 모습을 실시간 추적해 보안 및 범죄 예방에 도움 줄 수 있다.

차오닝 장 교수는 "MobileSAM은 최신의 컴퓨터 비전 연구에 새로운 가능성을 가지고 있다. 비전 기반 모델 경량화와 모바일 환경에서의 실시간 처리 가능성을 보여줬다"며 "더 많은 연구자가 MobileSAM을 활용해 혁신적인 응용 프로그램을 개발하길 기대한다"고 말했다.

홍충선 교수는 "이번 결과는 국내외 주목받는 연구 성과로 대한민국이 인공지능 분야에 역량을 한층 높인 사례다. 인공지능 분야의 선도자가 되기 위해 노력할 것"이라고 전했다.

banaffle@fnnews.com 윤홍집 기자

※ 저작권자 ⓒ 파이낸셜뉴스, 무단전재-재배포 금지