관련종목▶

차세대 AI 칩 GH200 선보이고 양산 계획 공개

대규모 언어모델 실행 비용 획기적으로 낮출것

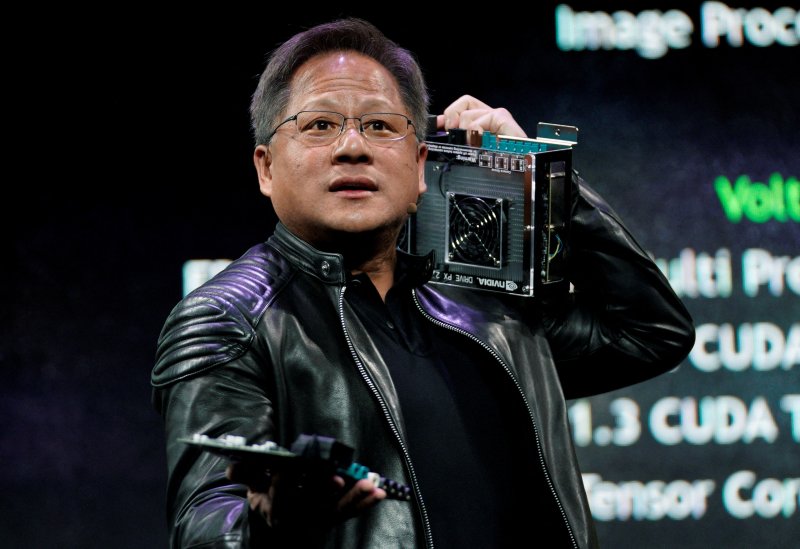

젠슨 황 CEO "고객들이 원하는 것 모두 가능" 자신감

대규모 언어모델 실행 비용 획기적으로 낮출것

젠슨 황 CEO "고객들이 원하는 것 모두 가능" 자신감

【실리콘밸리=홍창기 특파원】 엔비디아가 인공지능(AI) 모델 운영비용을 획기적으로 낮출 수 있는 향상된 AI 칩을 선보였다. AMD를 비롯해 구글과 아마존을 포함한 AI 하드웨어 분야에서 경쟁자들을 물리치기 위한 승부수를 던진 것이다.

8일(현지시간) 엔비디아는 미국 로스앤젤레스에서 열린 컴퓨터 그래픽스 콘퍼런스 시그래프에서 새로운 AI 칩 GH200를 선보였다.

GH200은 엔비디아의 현재 최고급 AI 칩인 H100과 동일한 그래픽처리장치(GPU)를 탑재하고 있다. 하지만 GH200은 이 GPU에 141기가바이트의 최첨단 메모리와 72코어 ARM(암) 중앙 프로세서(CPU)를 결합해 성능이 향상됐다는 평가다.

또 이 칩에는 초당 5테라바이트(TB)의 엄청난 속도로 정보에 접근할 수 있는 고대역폭 메모리 HBM3e가 탑재됐다. HBM은 여러 개의 D램을 수직으로 연결해 쌓아 기존 D램보다 데이터 처리 속도를 크게 끌어올린 메모리를 말하는데 HBM3e는 4세대 제품이다.

엔비디아의 GH200은 내년 2·4분기에 정식 출시될 예정이다. 올해 연말에는 샘플링이 가능할 것으로 예상된다.

젠슨 황 엔비디아 최고경영자(CEO)는 "우리는 이 CPU에 힘을 실어주고 있다"라고 말했다. 황 CEO는 "고객들은 그들이 원하는 거의 모든 대규모 언어 모델(LLM)을 GH200에 넣으면 된다"면서 "대규모 언어 모델의 추론 비용이 크게 낮아질 것"이라고 자신했다.

이안 벅 엔비디아 부사장은 "GH200은 더 많은 메모리 용량을 갖추고 있어 더 큰 AI 모델을 단일 시스템에 맞출 수 있다"고 설명했다.

엔비디아의 H100은 80GB의 메모리를 지원하지만 GH200은 141GB의 메모리를 탑재했다. 엔비디아는 또한 더 큰 모델을 위해 두 개의 GH200 칩을 하나의 컴퓨터로 결합하는 시스템도 발표했다.

엔비디아의 새로운 AI칩은 엔비디아의 GPU 라이벌인 AMD가 최근 192GB 메모리를 지원할 수 있는 자체 AI 지향 칩인 MI300X를 발표하고 AI 추론을 위한 용량으로 판매되고 있는 가운데 나왔다. 현재 구글과 아마존을 비롯한 기업들도 추론을 위한 자체 맞춤형 AI 칩을 설계하고 있다.

한편, CNBC에 따르면 엔비디아는 AI 반도체 시장에서 80% 이상의 점유율을 확보하고 있다. 엔비디아의 강점은 GPU인데 구글의 바드(Bard)나 오픈AI의 챗GPT 등 생성형 AI 소프트웨어를 뒷받침할 수 있어 대형 AI 모델에 선호되는 칩이 됐다. 빅테크와 클라우드 제공업체, 스타트업이 자체 AI 모델 개발을 위한 GPU 용량을 확보하기 위해 경쟁하면서 엔비디아의 칩에 대한 수요가 끊이질 않고 있다.

theveryfirst@fnnews.com 홍창기 기자

※ 저작권자 ⓒ 파이낸셜뉴스, 무단전재-재배포 금지